Cảnh báo dùng AI mạo danh người nổi tiếng

Chỉ cần vài giây ghép hình ảnh và giọng nói, đối tượng đã có thể tạo ra một video “người nổi tiếng” quảng cáo các ứng dụng vay tiền cấp tốc, cờ bạc online, bán các sản phẩm thực phẩm chức năng để lừa đảo. Công nghệ AI đang trở thành công cụ nguy hiểm tiếp tay cho các chiêu trò mạo danh, khiến người dùng mất tiền còn danh tiếng của người bị lợi dụng thì tổn hại nghiêm trọng.

Người nổi tiếng bị lôi vào các quảng cáo đen

Thời gian gần đây, nhiều nghệ sĩ đã lên tiếng cảnh báo về việc mình trở thành nạn nhân của công nghệ AI. Giữa tháng 6 vừa qua, ca sĩ Khắc Việt đã phải đăng đàn giải thích việc anh bị cắt ghép giọng nói và khuôn mặt bằng công nghệ deepfake để quảng bá cho các hình thức cờ bạc.

Trên trang cá nhân của mình, ca sĩ Khắc Việt viết: “Thông báo quan trọng - cảnh giác lừa đảo giả mạo: Gửi đến tất cả các bạn, hiện tại đang xuất hiện một video giả mạo, được cắt ghép giọng nói và khuôn mặt của tôi bằng công nghệ deepfake nhằm mục đích lừa đảo, quảng bá cho các hình thức cờ bạc. Tôi xin khẳng định rõ ràng rằng: Tôi chưa từng và sẽ không bao giờ tham gia hay quảng bá cho các hoạt động cờ bạc, lừa đảo hoặc các hình thức vi phạm pháp luật. Đây là hành vi vi phạm nghiêm trọng, không chỉ ảnh hưởng đến tôi mà còn có thể gây thiệt hại cho cộng đồng. Mong tất cả mọi người hãy tỉnh táo, cảnh giác cao độ, không tin - không chia sẻ - không tham gia bất kỳ đường link hay thông tin nào mạo danh tôi. Xin hãy cùng nhau chia sẻ thông tin này để mọi người không trở thành nạn nhân của các chiêu trò lừa đảo tinh vi”.

Ca sĩ Khắc Việt cho rằng, hiện nay khái niệm thật và giả trên mạng xã hội là ranh giới rất mong manh, nhất là đối với những người nhận thức chưa có độ sàng lọc thông tin sẽ khiến họ rất dễ tin vào những gì nhìn thấy. Nam ca sĩ cũng chia sẻ, người lớn tuổi như mẹ anh nếu xem được clip giả mạo sẽ hiểu nhầm con trai tiếp tay cho quảng cáo cờ bạc. Nam ca sĩ cho biết: “Cách nhấn nhá, ngữ điệu giống y hệt cách nói của tôi. Hình ảnh thì có thể người nào thông thạo sẽ nhận ra là có chỉnh sửa, nhưng việc ghép cũng rất mượt mà”.

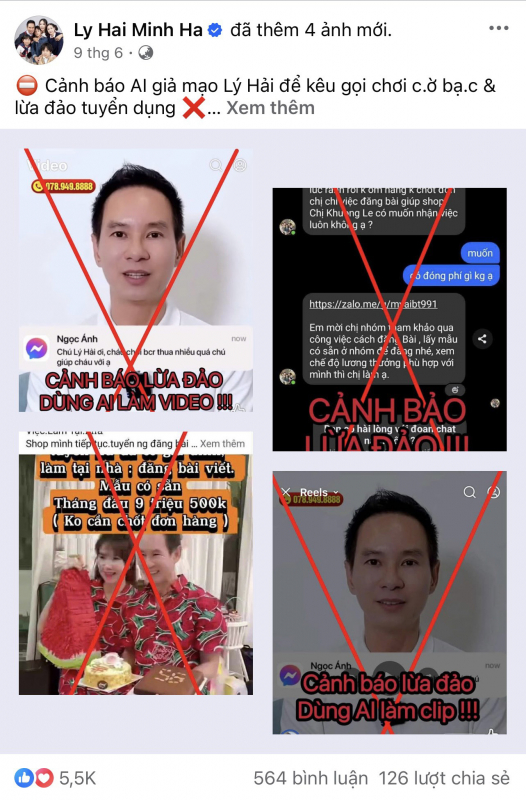

Tương tự, gia đình nghệ sĩ Lý Hải - Minh Hà cũng là nạn nhân của công nghệ AI. Cụ thể, tối 9/6, vợ chồng đạo diễn Lý Hải - Minh Hà đã đăng tải thông báo trên trang Facebook chính thức (hơn 5,7 triệu người theo dõi) về việc ca sĩ Lý Hải bị các đối tượng xấu sử dụng công nghệ AI để giả mạo hình ảnh, giọng nói, nhằm lôi kéo người dùng tham gia cờ bạc và lừa đảo tuyển dụng việc làm tại nhà. Trong video do AI tạo ra, ca sĩ Lý Hải đã nói: “Chú không biết cháu bao nhiêu tuổi và chú cũng không trong thị trường này nhưng chú biết một đứa em của chú đã kiếm được rất nhiều tiền từ Bacarat…” khi có người hỏi: “Chú Lý Hải ơi, cháu chơi Bacarat thua nhiều quá, chú giúp cháu với ạ”.

Theo chia sẻ của Minh Hà, vợ của ca sỹ Lý Hải thì video do AI tạo ra có độ chân thực cao, giả giọng Lý Hải rất giống, gây hiểu lầm cho người xem. Vợ chồng nghệ sĩ đã đăng tải video và đường link giả mạo ở phần bình luận bài viết, đồng thời kêu gọi cộng đồng cùng báo cáo (report) các nội dung vi phạm.

Ngoài clip giả, một số tài khoản Facebook và Zalo mạo danh gia đình Lý Hải - Minh Hà cũng xuất hiện, đăng tin tuyển dụng trái phép. Minh Hà khẳng định, fanpage chính thức của hai vợ chồng có dấu tick xanh, và mọi thông tin ngoài trang này đều là giả mạo.

Nhiều khán giả theo dõi trang fanpage cũng lên tiếng xác nhận họ từng nhận được tin nhắn rủ rê tham gia các hoạt động đáng ngờ từ tài khoản giả mạo. Một số người may mắn đã cảnh giác và từ chối, tuy nhiên không ít người tỏ ra lo ngại trước mức độ tinh vi của công nghệ lừa đảo bằng AI.

Trước đó, ca sĩ Đan Trường cũng đã lên tiếng về tình trạng các trang Facebook lấy hình ảnh của anh, chỉnh sửa mặt để đưa vào video quảng cáo dịch vụ cho vay nặng lãi. Trong video giả mạo mà nam ca sĩ cảnh báo, đối tượng xấu cắt ghép hình ảnh tinh vi, tạo nên kịch bản Đan Trường mời gọi khán giả sử dụng dịch vụ vay tiền nặng lãi. Fanpage đăng tải video còn chú thích: “Theo chân Đan Trường và Bá Long về quê hỗ trợ hai vợ chồng làm công nhân”.

Trước việc bị lợi dụng hình ảnh, nam ca sĩ kêu gọi khán giả nếu biết diễn viên trong clip giả mạo hình ảnh hãy cung cấp thông tin để phía Đan Trường báo cáo với cơ quan chức năng. Đồng thời nam ca sĩ cũng bày tỏ: “Các trang rác không được lấy hình ảnh của Đan Trường chỉnh sửa mặt mũi rồi giật tít câu view. Đó là hành vi vi phạm bản quyền. Một số video dùng AI lừa đảo chỉnh mặt Đan Trường biến dạng như vậy mà cũng có người tin”.

Không chỉ bị đối tượng xấu dùng công nghệ AI tạo video kêu gọi vay nặng lãi mà ca sĩ Đan Trường còn thường xuyên bị lấy hình ảnh lắp ghép vào các quảng cáo sữa hạt hay thực phẩm chức năng.

Gần đây nhất, trên trang TikTok của “Cô gái có râu” cũng đã đăng bài cảnh báo về việc ca sĩ Mỹ Tâm bị kẻ xấu dùng công nghệ AI cắt ghép tạo video quảng cáo cờ bạc online. Cụ thể, trong video cắt ghép, Mỹ Tâm giả quảng cáo: “Bacarat có boss nào kéo uy tín không ạ? Có em nha. Chị có đứa em Bá Long hoạt động trong ngành bacarat này đã lâu rồi. Bá Long đi kéo trực tiếp, tận nơi, người thật, việc thật luôn và cả kéo online cũng rất uy tín”. Khi xem video này, nhiều người đã để lại comment bày tỏ rằng “nếu không để ý kỹ thì y chang Mỹ Tâm thật” hay “Nếu ai không tỉnh táo thì chắc chắn bị lừa rồi”.

Cần tỉnh táo để phân biệt thật - giả

Theo các chuyên gia công nghệ, đây là sản phẩm của deepfake AI - công nghệ dùng trí tuệ nhân tạo để mô phỏng gương mặt, cử động môi và giọng nói y như thật từ video gốc. Chỉ cần vài phút từ video thật của một người nổi tiếng, AI có thể dựng lên clip hoàn toàn mới, khiến người xem rất khó phân biệt thật - giả.

Bằng các video giả mạo, những kẻ lừa đảo sử dụng hình ảnh và giọng nói của người nổi tiếng để giới thiệu ứng dụng “vay tiền siêu tốc, không cần thế chấp”. Trong video, “người nổi tiếng” thuyết phục rằng chỉ cần vài thao tác là có thể nhận tiền về tài khoản trong vòng 5 phút, lãi suất thấp, uy tín, không lo bị đòi nợ. Nhưng thực tế sau khi vay, người dùng mới “ngã ngửa” vì lãi suất cao ngất ngưởng, cộng thêm các loại phí dịch vụ, phí bảo hiểm “tự sinh” khiến số tiền phải trả tăng gấp 3-4 lần chỉ trong vài tuần.

Chưa kể, nếu chậm thanh toán, người vay bị gọi điện đe dọa, khủng bố tinh thần, thậm chí gửi hình ảnh cắt ghép phản cảm tới người thân, đồng nghiệp. Không ít người rơi vào cảnh khốn đốn, mất danh dự, ảnh hưởng tâm lý chỉ vì một cú click “vay nóng” được “người nổi tiếng” quảng bá trên mạng.

Song song với đó, nhiều clip AI giả mạo nghệ sĩ, hot TikToker... còn được dùng để quảng bá các nền tảng “giải trí online” - thực chất là sàn cá cược trá hình. Những nền tảng này thường đội lốt game tài xỉu, đua thú, xổ số, livestream chia thưởng... để lôi kéo người chơi. Người nổi tiếng giả mạo sẽ nói những câu quen thuộc như “Tôi chơi thử, không ngờ thắng đậm”, “Chơi vui mà ra tiền thật” - nhằm tạo cảm giác tin cậy.

Sau khi tham gia, người chơi phải nạp tiền thật để đổi thành “điểm” hoặc “xu”, rồi đặt cược. Khi thua, họ càng nạp thêm với hy vọng gỡ lại. Nhưng khi thắng lớn và muốn rút tiền, sàn sẽ liên tục báo lỗi, yêu cầu “xác minh” rồi chặn tài khoản. Tất cả chỉ là một trò bịp tinh vi được dựng sẵn để moi tiền của nạn nhân còn người nổi tiếng thật thì không hề hay biết mình đã bị sử dụng làm “mồi câu”.

Anh Lê Ngọc Hưng (Ứng Hòa, Hà Nội) không giấu được sự lo lắng khi chứng kiến sức “công phá” của các video do AI tạo ra. Anh Hưng cho biết: “Bản thân mình là người biết khá nhiều về công nghệ mà nhiều khi còn bị choáng trước độ như thật của các video do AI tạo ra thì nói gì đến những người già, trẻ nhỏ hay những người ít hiểu biết. Mới đây thôi, mình nghe mẹ mình thở dài bảo là: “Giờ đến những người nổi tiếng còn đi quảng cáo cờ bạc bịp thì đúng là xã hội loạn thật”. Nghe mẹ mình nói thế mà mình thấy giật mình, bởi bà đã không phân biệt được thật giả. Mình tin những người đang nhận thức như mẹ mình còn nhiều lắm. Như vậy sẽ khiến cho họ có cái nhìn lệch lạc và không còn nhiều niềm tin vào cuộc sống. Đó chính là mặt trái của AI”.

So với các hình thức lừa đảo truyền thống, AI mang lại cho kẻ gian lợi thế vượt trội: thao tác nhanh, chi phí thấp, dễ nhân bản và gần như không để lại dấu vết trực tiếp. Mỗi đoạn video deepfake có thể được chia sẻ hàng nghìn lần chỉ trong vài phút, lan truyền chóng mặt trên mạng xã hội mà nạn nhân không kịp phản ứng hay đính chính.

Đặc biệt, khi AI kết hợp với chatbot, giọng nói tổng hợp và dữ liệu cá nhân thu thập từ mạng xã hội, kẻ xấu có thể dựng lên một kịch bản lừa đảo “chân thực như đời thật”, khiến cả những người cẩn thận nhất cũng khó lòng nhận ra.

Không chỉ mạo danh người nổi tiếng, AI còn bị lợi dụng để giả mạo phát ngôn của các lãnh đạo doanh nghiệp, đại diện cơ quan chức năng nhằm lôi kéo người dân tham gia đầu tư, vay vốn, xin việc… Một số đối tượng còn dùng giọng nói AI để gọi điện mạo danh công an, viện kiểm sát, hù dọa nạn nhân “có liên quan đến vụ án” và yêu cầu chuyển tiền để chứng minh vô tội.

Những “cuộc gọi trí tuệ nhân tạo” này đánh trúng tâm lý lo lắng, thiếu hiểu biết về pháp luật của người dân, khiến nhiều người mất tiền trong tích tắc.

Theo chia sẻ của ông Cao Xuân Hoài Vương, Chủ tịch HĐQT AIVA Group (trợ lý ảo AI đầu tiên tại Việt Nam - PV) thì khoảng 70% người dùng không nhận ra đấy là video do AI tạo ra. Từ đó dẫn đến nguy cơ là người dùng sẽ bị lẫn lộn không biết đâu là thật và giả. Thông tin trên Internet giờ đây trở nên không đáng tin nữa, đồng thời nó cũng dẫn đến hệ lụy là, với những người thiếu hiểu biết sẽ có nguy cơ bị lừa đảo.

Theo các chuyên gia, AI thường chưa làm tốt phần chuyển động tự nhiên của khuôn mặt (chuyển động môi, mắt, nhíu mày). Nếu thấy chuyển động môi lệch nhịp so với âm thanh, biểu cảm “lạnh” hoặc không tự nhiên thì có quyền nghi ngờ. Ngoài ra, các video AI thường bị lỗi về ánh mắt (nhìn trân trân, không có phản xạ ánh sáng). Tần suất chớp mắt có thể không bình thường (quá ít hoặc quá nhiều). AI khó tái tạo chi tiết tai, tóc rối hoặc nền phức tạp. Có thể thấy các vùng bị nhòe, biến dạng hoặc rung lắc bất thường. Giọng nói giả AI đôi khi vẫn thiếu ngữ điệu cảm xúc, có thể nghe như “robot”. Một số từ bị đọc sai, phát âm méo mó.

AI là công cụ, không phải là thủ phạm. Cái đáng lo nhất không phải là công nghệ, mà là cách con người sử dụng nó. Nếu không có biện pháp kịp thời và quyết liệt, xã hội sẽ phải đối mặt với làn sóng lừa đảo mới - nơi niềm tin bị đánh cắp bởi những gương mặt nổi tiếng được “nhân bản” bởi máy móc.

Sử dụng AI, Facebook muốn ngăn nội dung khiêu dâm

Sử dụng AI, Facebook muốn ngăn nội dung khiêu dâm  Tính hai mặt của AI

Tính hai mặt của AI