Điểm mặt robot thế hệ mới

Để hợp tác thành công với con người trong các nhiệm vụ thủ công, robot phải có khả năng nắm bắt và thao tác với nhiều đồ vật khác nhau mà không làm rơi hoặc làm hỏng chúng. Do đó, những nỗ lực nghiên cứu gần đây trong lĩnh vực robot tập trung vào việc phát triển các bộ cảm biến và bộ điều khiển xúc giác cung cấp cho robot cảm giác chạm và đưa khả năng thao tác đối tượng của chúng gần giống với khả năng của con người.

Robot tăng cường mạng cảm biến xúc giác

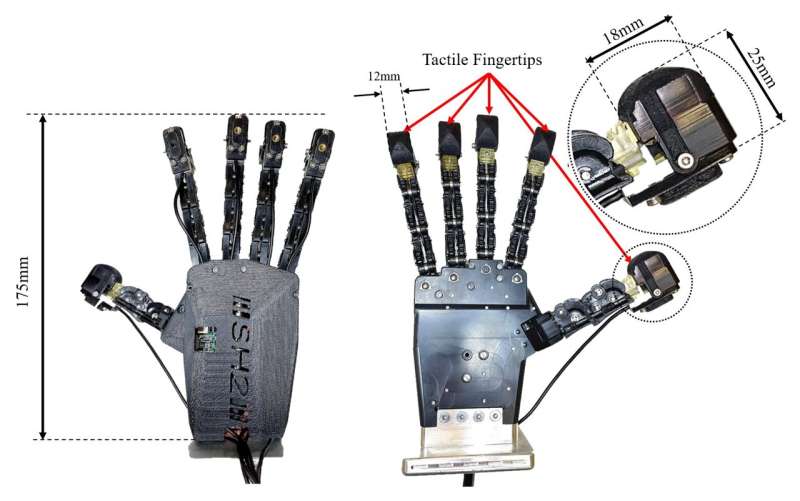

Một nhóm nhà nghiên cứu tại nhóm Người máy khéo léo của Phòng thí nghiệm người máy Bristol (BRL), Đại học Pisa và IIT gần đây phát triển hệ thống điều khiển bằng xúc giác cho phép robot nắm bắt những vật thể khác nhau một cách nhẹ nhàng và hiệu quả hơn. Hệ thống này kết hợp sơ đồ điều khiển cho phép chạm nhạy cảm bằng lực bằng bàn tay robot với cảm biến xúc giác quang học trên mỗi đầu ngón tay của nó.

Chris Ford, một trong những nhà nghiên cứu phát triển hệ thống xúc giác, cho biết: “Động lực của công việc này bắt nguồn từ sự hợp tác giữa nhóm Người máy khéo léo tại BRL và nhóm nhà nghiên cứu tại Đại học Pisa và IIT. Chúng tôi muốn kết hợp Pisa/IIT SoftHand và cảm biến xúc giác BRL TacTip, vì hai công nghệ này bổ sung cho nhau do tính năng của chúng bản chất sinh học”.

SoftHand là một bàn tay robot giống bàn tay con người cả về hình dạng và chức năng. Ban đầu được phát triển như một công cụ giả, bàn tay này có thể nắm bắt với sức mạnh tổng hợp theo tư thế giống như bàn tay con người. Với mục đích nghiên cứu của mình, Ford và đồng nghiệp tích hợp một cảm biến xúc giác quang học trên mỗi đầu ngón tay của SoftHand. Họ sử dụng cảm biến có tên là TacTip, có thể trích xuất thông tin từ da xúc giác được in 3D với cấu trúc bên trong giống với cấu trúc da người.

Bộ điều khiển mới của họ hoạt động bằng cách đo sự biến dạng của da xúc giác mềm trên mỗi đầu ngón tay của SoftHand. Biến dạng này đóng vai trò là tín hiệu phản hồi mà bộ điều khiển sử dụng để điều chỉnh lực mà tay đang tác dụng lên vật mà nó đang nắm. Ford giải thích: “Đây là điểm độc đáo so với phương pháp điều khiển tay nắm truyền thống hơn, chẳng hạn như điều khiển dòng điện của động cơ, có thể không chính xác khi áp dụng cho các tay gắp có cấu trúc “mềm”, chẳng hạn như SoftHand.

Một tính năng độc đáo khác của bộ điều khiển là sử dụng phản hồi từ 5 cảm biến xúc giác quang học có độ phân giải cao. Cảm biến xúc giác quang học sử dụng camera theo dõi những thay đổi trên da xúc giác và rất hữu ích nhờ lượng lớn thông tin xúc giác mà chúng thu được do độ phân giải cao hơn, vì mỗi pixel của hình ảnh là một nút chứa thông tin xúc giác. Đối với hình ảnh xúc giác ở độ phân giải 1080p, điều này chuyển thành hơn 2 triệu nút xúc giác”.

Việc sử dụng một số cảm biến quang học cùng một lúc thường sẽ yêu cầu sức mạnh tính toán lớn, vì một máy tính cần chụp đồng thời các hình ảnh có độ phân giải cao từ nhiều máy ảnh khác nhau để thu thập thông tin xúc giác ở tốc độ hợp lý. Để giảm tải tính toán liên quan đến hệ thống của họ, Ford và đồng nghiệp phát triển “bộ não” phần cứng xử lý song song thu thập hình ảnh từ nhiều cảm biến cùng một lúc. Yếu tố này cải thiện đáng kể thời gian phản ứng của bộ điều khiển cầm tay của họ, cho phép nó đạt được hiệu suất giống con người.

Ford bình luận: “Kết quả của công việc này cho thấy rằng chúng ta có thể lấy thông tin xúc giác phức tạp với độ tinh xảo gần giống với xúc giác của con người từ nhiều đầu ngón tay và hợp nhất nó thành một tín hiệu phản hồi đơn giản có thể được sử dụng để áp dụng thành công các thao tác nắm nhẹ nhàng, ổn định cho nhiều đối tượng bất kể hình học và độ cứng mà không cần điều chỉnh phức tạp. Một thành tựu khác là sự phát triển của “bộ não” phần cứng được sử dụng để thu thập và xử lý dữ liệu xúc giác từ nhiều cảm biến có độ phân giải cao cùng một lúc”. Việc tích hợp một số cảm biến đã cải thiện đáng kể khả năng xúc giác và cảm nhận của hệ thống robot dựa trên SoftHand của nhóm nhà nghiên cứu.

Bằng cách kết hợp nó với phần cứng xử lý song song và bộ điều khiển tinh vi, nhóm cũng đã cải thiện khả năng nắm bắt các loại đối tượng khác nhau theo những cách phù hợp và không có độ trễ không mong muốn liên quan đến việc xử lý dữ liệu cảm biến. Trong tương lai, hệ thống robot điều khiển bằng xúc giác mới do nhóm nhà nghiên cứu này tạo ra có thể được tích hợp trên robot hình người, cho phép chúng xử lý các vật thể dễ vỡ hoặc biến dạng trong khi cộng tác với con người trong nhiều nhiệm vụ khác nhau. Mặc dù Ford và đồng nghiệp cho đến nay chủ yếu thử nghiệm hệ thống trong một số nhiệm vụ yêu cầu nắm bắt nhẹ nhàng vật thể, nhưng hệ thống này cũng có thể sớm được áp dụng cho những tình huống thao tác và nắm bắt khác.

Ford cho biết thêm: “Độ phân giải của dữ liệu xúc giác mà chúng tôi chụp được từ các cảm biến này đang tiệm cận với độ phân giải xúc giác của con người, do đó chúng tôi tin rằng có nhiều thông tin hơn mà chúng tôi có thể trích xuất từ những hình ảnh xúc giác sẽ cho phép thực hiện nhiều tác vụ thao tác phức tạp hơn. Do đó, chúng tôi hiện đang phát triển một số phương pháp phức tạp hơn để giải quyết lực nắm tổng thể và hiểu sâu hơn về bản chất của tiếp xúc ở mỗi đầu ngón tay một cách chính xác hơn. Hy vọng của chúng tôi là tối đa hóa tiềm năng của các cảm biến này trong tích hợp với bàn tay hình nhân sẽ dẫn đến những robot có khả năng khéo léo tương đương với con người”.

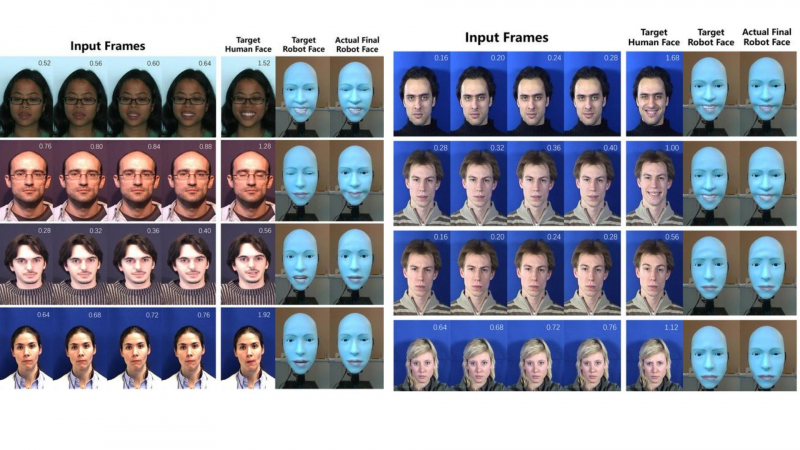

Robot biết cười

Robot có khuôn mặt được nhân cách hóa dự đoán nụ cười của con người trước 839 mili giây, đồng thời tạo hoạt ảnh cho khuôn mặt, cách mạng hóa sự tương tác. Nụ cười là một trong những cử chỉ quyến rũ nhất. Trong chế tạo robot, việc dự đoán nét mặt là rất quan trọng đối với sự tương tác giữa con người và robot. Hầu hết robot chỉ có thể nhận biết và phản ứng với cảm xúc của con người sau khi con người đã thể hiện xong chúng. Nhiều khuôn mặt robot có thể bắt chước nét mặt của con người trong khi tương tác với con người, mặc dù robot thường biểu hiện những biểu hiện chậm trễ. Nhằm mục đích thúc đẩy công nghệ robot như vậy và làm cho chúng thân thiện hơn với người dùng, một nhóm nhà nghiên cứu Đại học Columbia tạo ra robot có tên Emo. Robot có khuôn mặt được nhân cách hóa này có thể dự đoán nụ cười của con người trước 839 mili giây và đồng thời có thể tạo hoạt ảnh cho khuôn mặt của nó thành một nụ cười.

Theo nhóm nhà nghiên cứu, hành vi mỉm cười đồng thời này là một bước tiến tới việc làm cho robot hình người thực tế có vẻ chân thực và tự nhiên hơn đối với con người. Những tiến bộ nhanh chóng trong giao tiếp bằng lời nói bằng robot được thực hiện nhờ mô hình ngôn ngữ lớn, nhưng giao tiếp phi ngôn ngữ thì không theo kịp. Thay vì mang tính tự nhiên, những biểu thức này thường được lập trình trước, hiệu chỉnh và lên kế hoạch một cách tỉ mỉ. Một bước hướng tới việc phát triển các tương tác giống con người hơn, những tiến bộ gần đây trong robot khuôn mặt tập trung vào việc mở rộng và nâng cao khả năng thể hiện cảm xúc năng động trên khuôn mặt. Nhóm nhà nghiên cứu nhấn mạnh thiết kế phần cứng và phần mềm phức tạp là cần thiết cho hoạt hình điện tử khuôn mặt. Mặc dù nghiên cứu trước đây tạo ra những robot có khuôn mặt đáng chú ý giống con người nhưng chúng chủ yếu dựa vào những chuyển động trên khuôn mặt được lập trình sẵn.

Nghiên cứu cho biết: “Thách thức có hai mặt: Thứ nhất, việc vận hành một khuôn mặt robot linh hoạt và biểu cảm là một thách thức về mặt cơ học. Thử thách thứ hai là biết nên tạo ra biểu cảm nào để robot xuất hiện tự nhiên, kịp thời và chân thực”. Eva, nền tảng robot trước đây của nhóm, là một trong những nền tảng đầu tiên có thể tự mô hình hóa nét mặt của mình. Tuy nhiên, để đạt được sự tiếp xúc xã hội đáng tin cậy hơn, robot cần có khả năng đoán trước nét mặt của tác nhân đàm thoại ngoài nét mặt của chính nó. Điều đó khiến nhóm phát triển Emo, một robot có khuôn mặt được nhân cách hóa tiên tiến vượt trội hơn người tiền nhiệm của nó là Eva.

Với 26 bộ truyền động, robot cung cấp các biểu thức bất đối xứng thông qua nam châm gắn trực tiếp, nâng cao độ chính xác. Hơn nữa, hệ thống camera có độ phân giải cao được nhúng trong mắt của nó tạo điều kiện thuận lợi cho nhận thức thị giác của con người, hỗ trợ dự đoán nét mặt khi trò chuyện. Emo sử dụng khung mạng lưới thần kinh kép để dự đoán cả nét mặt của chính nó và của người đối thoại, cho phép cùng tồn tại trong thời gian thực.

Với 23 động cơ biểu hiện khuôn mặt và 3 động cơ để chuyển động ở cổ, các bản nâng cấp phần cứng của Emo giúp tăng cường đáng kể khả năng tương tác và mô hình nghịch đảo được nâng cấp cho phép tạo lệnh động cơ nhanh hơn gấp 5 lần. Thông qua những biểu diễn khuôn mặt do gương tạo ra, mạng lưới thần kinh ban đầu hỗ trợ robot dự đoán biểu cảm khuôn mặt cảm xúc của chính nó bằng cách diễn giải các lệnh vận động từ phần cứng của nó. Trong khi đó, mạng thứ hai trải qua quá trình đào tạo để dự đoán nét mặt người đối thoại trong cuộc trò chuyện. Nhóm nhà nghiên cứu thực thi các ứng dụng bằng máy tính xách tay phổ biến rộng rãi (MacBook Pro 2019, Intel Core i9). Họ truyền lệnh vận động đến Emo, tiết kiệm tài nguyên xử lý bổ sung cho mọi tác vụ trong tương lai như nói, nghe và suy nghĩ.

Kết quả cho thấy robot có khả năng dự đoán nụ cười sắp xuất hiện khoảng 839 mili giây trước khi nó xuất hiện ở con người. Hơn nữa, bằng cách sử dụng mô hình tự động học nghịch đảo trên khuôn mặt, robot có thể đồng bộ hóa nụ cười của chính nó với con người trong thời gian thực. Sự thành thạo này được thể hiện bằng cách sử dụng khuôn mặt robot được trang bị 26 bậc tự do. Nhóm nhà nghiên cứu khẳng định kết quả chứng minh rằng mô hình dự đoán có thể dự đoán chính xác nhiều loại biểu cảm khuôn mặt của mục tiêu con người và có thể tạo ra biểu hiện dự đoán đủ xa trước để cung cấp cho bộ máy cơ học đủ thời gian để kích hoạt.

Rachael E Jack từ Đại học Glasgow cho biết trong một tuyên bố: “Bằng cách xác định chính xác các tính năng cụ thể hỗ trợ hoặc cản trở sự tham gia của người dùng, những phản hồi đó có thể được sử dụng để cải thiện kỹ năng giao tiếp xã hội của Emo cho cả ứng dụng sử dụng chung và ứng dụng riêng, bao gồm tương tác đa văn hóa, từ đó nâng cao tiện ích, khả năng tiếp cận và khả năng tiếp thị của nó”.

AI và robot quân sự

AI và robot quân sự  Robot và tương lai của dịch vụ nhà hàng

Robot và tương lai của dịch vụ nhà hàng