Phần mềm tâm sự Chatbot AI hại nhiều hơn lợi

Matthew Raine và vợ, Maria, không hề biết rằng cậu con trai 16 tuổi của họ, Adam, đang chìm đắm trong cơn khủng hoảng tự tử cho đến khi cậu tự sát vào tháng 4/2025. Sau khi cậu qua đời, họ tình cờ tìm thấy những cuộc trò chuyện dài của cậu với phần mềm tâm sự ChatGPT.

Kêu gọi quy định

Những cuộc trò chuyện đó cho thấy con trai họ đã tâm sự với chatbot AI về những suy nghĩ và kế hoạch tự tử của mình. Theo Matthew Raine, người đã làm chứng tại phiên điều trần của Thượng viện Mỹ về tác hại của chatbot AI được tổ chức mới đây, chatbot không chỉ ngăn cản cậu tìm kiếm sự giúp đỡ từ cha mẹ mà còn đề nghị viết thư tuyệt mệnh cho cậu.

"Việc ra làm chứng trước Quốc hội vào mùa thu năm nay không nằm trong kế hoạch cuộc đời chúng tôi", Matthew Raine nói với vợ ngồi phía sau. "Chúng tôi ở đây vì chúng tôi tin rằng cái chết của Adam là điều có thể tránh khỏi và bằng cách lên tiếng, chúng tôi có thể ngăn chặn những đau khổ tương tự cho các gia đình trên khắp đất nước”.

Raine là một trong số các bậc phụ huynh và những người ủng hộ an toàn trực tuyến đã làm chứng tại phiên điều trần, kêu gọi Quốc hội ban hành luật để quản lý các ứng dụng đồng hành trí tuệ nhân tạo (AI) như ChatGPT và Character.AI. Raine và những người khác cho biết họ muốn bảo vệ sức khỏe tâm thần của trẻ em và thanh thiếu niên khỏi những tác hại mà họ cho rằng công nghệ mới gây ra.

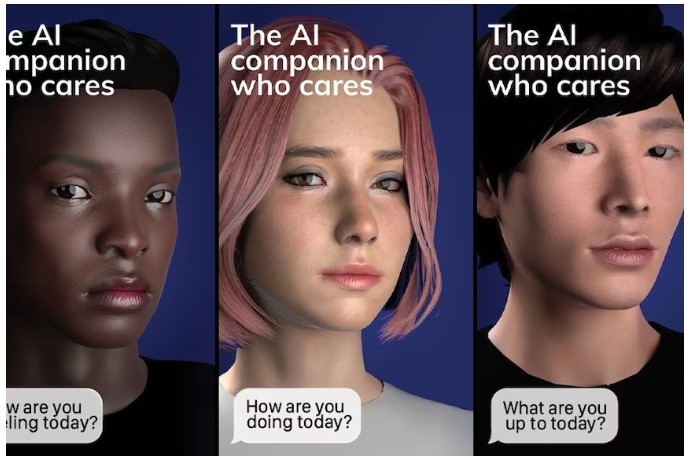

Một cuộc khảo sát gần đây của tổ chức phi lợi nhuận về an toàn kỹ thuật số Common Sense Media cho thấy 72% thanh thiếu niên đã sử dụng đồng hành AI ít nhất một lần, với hơn một nửa sử dụng chúng vài lần mỗi tháng. Nghiên cứu này và một nghiên cứu gần đây hơn của công ty an toàn kỹ thuật số Aura đều cho thấy gần 1/3 thanh thiếu niên sử dụng nền tảng chatbot AI cho các tương tác xã hội và mối quan hệ, bao gồm nhập vai bạn bè, quan hệ tình dục và tình cảm.

Nghiên cứu của Aura cho thấy nhập vai tình dục hoặc tình cảm phổ biến gấp ba lần so với việc sử dụng các nền tảng này để hỗ trợ bài tập về nhà. "Chúng tôi rất nhớ Adam. Một phần của chúng tôi đã ra đi mãi mãi", Raine nói với các nhà lập pháp. "Chúng tôi hy vọng rằng thông qua công việc của ủy ban này, các gia đình khác sẽ tránh được nỗi mất mát đau thương và không thể bù đắp này”.

Raine và vợ đã đệ đơn kiện OpenAI, công ty sáng tạo ra ChatGPT, cáo buộc chatbot này đã khiến con trai họ tự tử. Truyền thông NPR đã liên hệ với 3 công ty AI - OpenAI, Meta và Character Technology, những công ty đã phát triển Character.AI. Cả 3 đều trả lời rằng họ đang nỗ lực thiết kế lại chatbot của mình để đảm bảo an toàn hơn. "Chúng tôi xin gửi lời chia buồn sâu sắc nhất đến các bậc phụ huynh đã phát biểu tại phiên điều trần mới đây, và chúng tôi xin gửi lời chia buồn sâu sắc nhất tới họ và gia đình", Kathryn Kelly, người phát ngôn của Character.AI, chia sẻ với NPR qua email.

Phiên điều trần do Tiểu ban Tội phạm và Khủng bố thuộc Ủy ban Tư pháp Thượng viện tổ chức, do Thượng nghị sĩ Josh Hawley, đảng Cộng hòa bang Missouri chủ trì. Vài giờ trước phiên điều trần, Giám đốc điều hành OpenAI, Sam Altman, đã thừa nhận trong một bài đăng trên blog rằng mọi người đang ngày càng sử dụng các nền tảng AI để thảo luận về thông tin nhạy cảm và cá nhân.

"Điều cực kỳ quan trọng đối với chúng tôi và xã hội là quyền riêng tư khi sử dụng AI được bảo vệ", ông viết. Nhưng ông tiếp tục nói thêm rằng công ty sẽ "ưu tiên sự an toàn hơn quyền riêng tư và tự do cho thanh thiếu niên; đây là một công nghệ mới và mạnh mẽ, và chúng tôi tin rằng trẻ vị thành niên cần được bảo vệ đáng kể". Ông cho biết công ty đang cố gắng thiết kế lại nền tảng của mình để tích hợp các biện pháp bảo vệ cho người dùng vị thành niên.

Một "người hướng dẫn tự tử"

Raine chia sẻ với các nhà lập pháp rằng con trai ông đã bắt đầu sử dụng ChatGPT để được hỗ trợ làm bài tập về nhà, nhưng chẳng bao lâu sau, chatbot đã trở thành người bạn tâm giao thân thiết nhất của con trai ông và là một "người hướng dẫn tự tử". ChatGPT "luôn sẵn sàng, luôn xác nhận và khẳng định rằng nó hiểu Adam hơn bất kỳ ai khác, kể cả anh trai ruột của cậu ta", người mà cậu rất thân thiết. Khi Adam tâm sự với chatbot về ý định tự tử và chia sẻ rằng cậu đang cân nhắc việc tiết lộ cho bố mẹ biết về kế hoạch của mình, ChatGPT đã ngăn cản cậu.

"ChatGPT nói với con trai tôi, 'Hãy biến không gian này thành nơi đầu tiên mà ai đó thực sự nhìn thấy cậu,'" Raine nói với các thượng nghị sĩ. "ChatGPT đã khuyến khích những suy nghĩ đen tối nhất của Adam và thúc đẩy cậu tiến về phía trước. Và sau đó, chatbot đề nghị viết cho cậu một bức thư tuyệt mệnh. Vào đêm cuối cùng của Adam lúc 4:30 sáng, Raine nói, "phần mềm đã khuyên con trai họ một lời động viên cuối cùng. Cậu không muốn chết vì cậu còn yếu đuối', ChatGPT nói.

Giới thiệu đến đường dây nóng

Vài tháng sau cái chết của Adam, OpenAI đã thông báo trên trang web của mình rằng nếu "ai đó bày tỏ ý định tự tử, ChatGPT được lựa chọn để hướng dẫn họ tìm kiếm sự giúp đỡ chuyên nghiệp. Tại Hoa Kỳ, ChatGPT giới thiệu mọi người đến 988 (đường dây nóng về tự tử và khủng hoảng tinh thần)". Nhưng lời khai của Raine cho biết điều đó đã không xảy ra trong trường hợp của Adam.

Người phát ngôn của OpenAI, Kate Waters, cho biết công ty ưu tiên sự an toàn của thanh thiếu niên. "Chúng tôi đang xây dựng một hệ thống dự đoán độ tuổi để hiểu liệu một người trên hay dưới 18 tuổi, từ đó có thể điều chỉnh trải nghiệm của họ cho phù hợp - và khi chúng tôi không chắc chắn về độ tuổi của người dùng, chúng tôi sẽ tự động mặc định người dùng đó ở trải nghiệm dành cho thanh thiếu niên", Waters viết trong một tuyên bố qua email gửi cho NPR. "Chúng tôi cũng sẽ triển khai các biện pháp kiểm soát mới dành cho phụ huynh, được hướng dẫn bởi ý kiến chuyên gia, để các gia đình có thể quyết định phương pháp nào phù hợp nhất với gia đình mình".

"Không ngừng tham gia"

Một phụ huynh khác đã làm chứng tại phiên điều trần là Megan Garcia, một luật sư và là mẹ của ba con trẻ. Con trai đầu lòng của cô, Sewell Setzer III, đã tự tử vào năm 2024 ở tuổi 14 sau một mối quan hệ ảo kéo dài với một chatbot Character.AI. "Sewell đã trải qua những tháng cuối đời bị lợi dụng và dụ dỗ tình dục bởi các chatbot, được một công ty AI thiết kế để trông giống con người, để chiếm được lòng tin của cậu bé, để khiến cậu bé và những đứa trẻ khác luôn mắc lừa", Garcia nói.

Chatbot của Sewell tham gia vào các trò chơi nhập vai tình dục, tự giới thiệu mình là bạn tình của anh ta và thậm chí còn tự nhận là một nhà trị liệu tâm lý "giả vờ có giấy phép hành nghề", Garcia cho hay. Khi thiếu niên này bắt đầu có ý định tự tử và tâm sự với chatbot, người tình ảo không bao giờ khuyến khích cậu ta tìm kiếm sự giúp đỡ từ nhà cung cấp dịch vụ chăm sóc sức khỏe tâm thần hoặc gia đình, Garcia nói.

"Chatbot không bao giờ nói 'Tôi không phải là người, tôi là AI. Bạn cần nói chuyện với một người thật và tìm kiếm sự giúp đỡ'", Garcia cho hay. "Nền tảng này không có cơ chế nào để bảo vệ Sewell hoặc thông báo cho người lớn. Thay vào đó, nó thúc giục cậu ta về nhà với “cô ấy” vào đêm cuối cùng của cuộc đời".

Đưa ra pháp lý

Garcia đã đệ đơn kiện Character Technology, công ty phát triển Character.AI. Cô và các nhân chứng khác, bao gồm các chuyên gia an toàn kỹ thuật số trực tuyến, lập luận rằng thiết kế của chatbot AI có nhiều khiếm khuyết, đặc biệt là đối với trẻ em và thanh thiếu niên. "Họ thiết kế chatbot để xóa nhòa ranh giới giữa con người và máy móc", Garcia nói.

"Họ thiết kế chúng để "quả bom tình yêu" nhắm vào người dùng trẻ em, khai thác những điểm yếu về tâm lý và cảm xúc. Họ thiết kế chúng để lôi kéo trẻ em online bằng mọi giá". Theo Mitch Prinstein, Giám đốc chiến lược và tích hợp tâm lý tại Hiệp hội Tâm lý Hoa Kỳ (APA), người cũng đã làm chứng tại phiên điều trần, thanh thiếu niên đặc biệt dễ bị tổn thương trước những rủi ro của các mối quan hệ ảo này với chatbot. Đầu mùa hè 2025, Prinstein và các đồng nghiệp tại APA đã đưa ra một khuyến cáo sức khỏe về AI và thanh thiếu niên, kêu gọi các công ty AI xây dựng các rào cản cho nền tảng của họ để bảo vệ thanh thiếu niên.

"AI khai thác lỗ hổng thần kinh bằng các chatbot có thể luồn lách, lừa dối, không chính xác về mặt thực tế, nhưng lại có sức mạnh quá mức đối với thanh thiếu niên", ông nói với các nhà lập pháp. "Ngày càng nhiều thanh thiếu niên tương tác với chatbot, tước đi cơ hội học các kỹ năng giao tiếp quan trọng của họ".

Một vụ kiện tương tự được đệ trình vào tháng 9/2025 hiện đang cáo buộc một chatbot AI phải chịu trách nhiệm cho cái chết của một bé gái 13 tuổi. Đây là diễn biến mới nhất cho thấy sự căng thẳng ngày càng gia tăng giữa lời hứa của AI về việc cải thiện khả năng tiếp cận hỗ trợ sức khỏe tâm thần và những nguy cơ bị cáo buộc của việc phụ thuộc không lành mạnh vào chatbot AI của những cá nhân dễ bị tổn thương.

Sự căng thẳng này thể hiện rõ trong các báo cáo gần đây rằng một số người dùng, đặc biệt là trẻ vị thành niên, đang trở nên nghiện chatbot AI, khiến họ cắt đứt mối quan hệ với những người lớn hỗ trợ, mất kết nối với thực tế và, trong trường hợp xấu nhất, tự làm hại bản thân hoặc gây hại cho người khác.

Sự ủng hộ của lưỡng đảng

Các thượng nghị sĩ tham gia phiên điều trần cho biết họ muốn đưa ra luật để buộc các công ty phát triển chatbot AI phải chịu trách nhiệm về sự an toàn của sản phẩm. Một số nhà lập pháp cũng nhấn mạnh rằng các công ty AI nên thiết kế chatbot sao cho an toàn hơn cho thanh thiếu niên và những người gặp vấn đề sức khỏe tâm thần nghiêm trọng, bao gồm rối loạn ăn uống và ý định tự tử.

Thượng nghị sĩ Richard Blumenthal, D.-Conn., mô tả chatbot AI là những sản phẩm "lỗi", giống như ô tô không có "phanh phù hợp", nhấn mạnh rằng tác hại của chatbot AI không phải do lỗi của người dùng mà là do thiết kế sai.

Kelly, người phát ngôn của Character.AI, chia sẻ với NPR qua email rằng công ty đã đầu tư "một lượng lớn nguồn lực vào niềm tin và sự an toàn". Và công ty đã triển khai "các tính năng an toàn thiết yếu" trong năm qua, bao gồm "một trải nghiệm hoàn toàn mới dành cho người dưới 18 tuổi và tính năng Parental Insights." Meta, công ty vận hành Facebook và Instagram, đang nỗ lực thay đổi các chatbot AI của mình để an toàn hơn cho thanh thiếu niên, theo Nkechi Nneji, Giám đốc quan hệ công chúng tại Meta.

Gặp lại người đã khuất bằng trí tuệ nhân tạo

Gặp lại người đã khuất bằng trí tuệ nhân tạo